Il professor Fabio Giglietto, docente di Internet studies alla guida del progetto Social Media & Democracy

L’articolo scientifico Coordinated Link Sharing Behavior as a Signal to Surface Sources of Problematic Information on Facebook è il lavoro più recente che illustra i risultati della ricerca condotta dal gruppo di lavoro dell’Università degli studi di Urbino guidato da Fabio Giglietto e composto da Nicola Righetti, Luca Rossi e Giada Marino. Lo studio prende in esame l’impatto delle notizie false nell’ecosistema dei media, con particolare riferimento ai social media.

“Il progetto Social Media & Democracy sviluppato dal LaRiCA, il Laboratorio di Ricerca sulla Comunicazione Avanzata dell’Università di Urbino, è in parte finanziato da un grant del Social Science Research Council” spiega Fabio Giglietto, docente di Internet studies. “Abbiamo iniziato la nostra analisi durante le elezioni del 2018 mettendo a punto un software in grado di identificare possibili minacce provenienti da contenuti problematici. A febbraio, con la prima ondata pandemica, abbiamo spostato la nostra attenzione sul Coronavirus. Il clima di incertezza e la percezione dell’importanza del tema hanno creato le condizioni ideali per il proliferare di rumors e notizie non verificate. Le nostre ricerche approfondiscono i tentativi di manipolare l’opinione pubblica e l’azione di gruppi che generano caos producendo e diffondendo informazioni false”.

“Social Media & Democracy – evidenzia il professor Giovanni Boccia Artieri, direttore del centro LaRiCA – rientra nella nostra mission di sviluppare progetti di ricerca che riguardino il rapporto fra opinione pubblica, ambienti digitali e territori della disinformazione e misinformazione, così come quella della manipolazione online, che rappresentano un elemento oggi particolarmente sensibile per una cittadinanza informata”.

Giada Marino, Fabio Giglietto, Nicola Righetti nel giardino di Google

Non chiamatele fake news

Il primo chiarimento utile riguarda proprio il glossario fondamentale: “Non parliamo di fake news – riprende il professor Giglietto – perché spesso accade che i contenuti sfruttati per manipolare l’opinione pubblica non siano falsi, ma riferiti ad un contesto diverso da quello di provenienza. Un’immagine reale, se riferita ad una situazione differente dal contesto che l’ha prodotta, ha un significato completamente diverso”. Ed è proprio nell’uso di una definizione più corretta, “contenuti problematici”, che si mette in moto un vero e proprio sistema immunitario dell’informazione online.

Il software “antibufale”

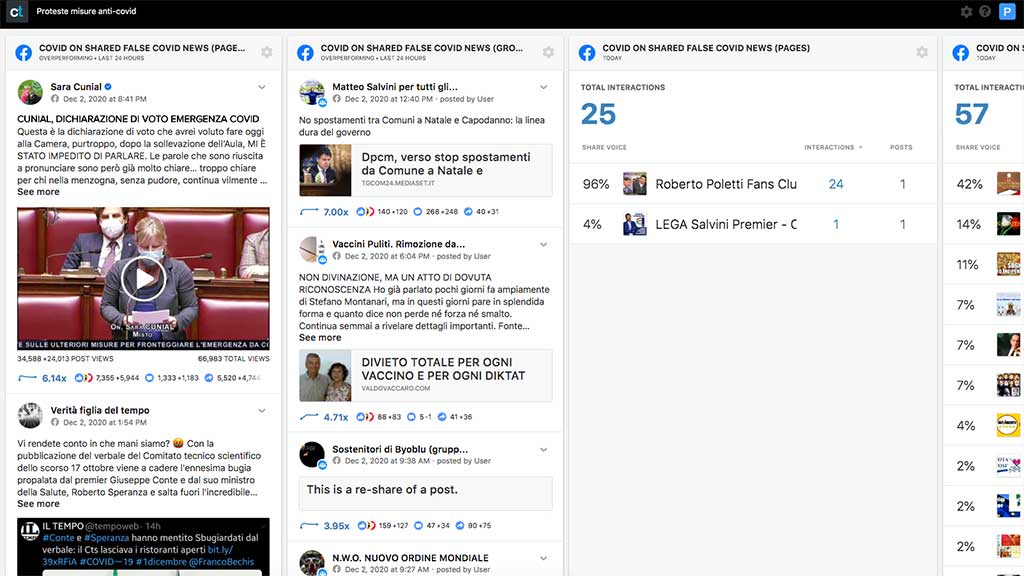

“Il software che utilizziamo non analizza il contenuto, nessun programma, per quanto sofisticato, riuscirebbe a stabilire se una notizia sia vera o falsa. Si basa piuttosto sul comportamento delle fonti che producono e condividono i contenuti. Attraverso un set di parole chiave che filtra le news condivise in pagine o gruppi nell’arco dei primi 15/20 secondi di vita, riusciamo a selezionare l’argomento che interessa la nostra ricerca e a risalire alle fonti, individuando quelle che chiamiamo condivisioni coordinate. Il resharing coordinato è un indice importante: i siti, le pagine social, i gruppi che fanno disinformazione tendono infatti a promuovere contenuti critici in modo strategico e ripetuto. Abbiamo inoltre notato che chi ha condiviso notizie di questo tipo è solitamente portato a rifarlo”.

Fact checkers: l’uomo in aiuto della macchina

Uno dei processi fondamentali del lavoro di verifica delle notizie ha bisogno di qualcosa che nessun algoritmo, nessuna intelligenza artificiale, è riuscita a rimpiazzare: la capacità critica dell’uomo. “L’identificazione di notizie false nell’ultima fase di verifica – chiarisce il professor Giglietto – richiede necessariamente il coinvolgimento di fact checkers, vale a dire di giornalisti specializzati che abbiano anche una buona conoscenza della rete e di come funzioni il web. Sono loro che riescono a stabilire se un contenuto sia valido. Durante le recenti elezioni presidenziali negli Stati Uniti, ho avuto modo di osservare una costruttiva collaborazione fra giornalisti investigativi, responsabili della sicurezza delle piattaforme di social media e docenti universitari”.

Gli Usa, l’Europa, l’Italia: sistemi a confronto

Premettendo che “l’improbabile circola molto più facilmente del probabile” e che, quindi, la battaglia contro fake news e contenuti critici è molto complessa, talvolta impari, ci sono tuttavia differenze nel modo di affrontarla che possono determinare un recupero sulle fonti di disinformazione seriale. “Negli Stati Uniti – prosegue il professor Fabio Giglietto – esiste una task force che fa parte dell’International Fact-Checking Network (IFCN) composta da circa 15 fact checkers sottoscrittori di un accordo con Facebook. La piattaforma li ha dotati di un’applicazione che raccoglie le notizie segnalate dagli utenti. I fact checkers verificano il contenuto redigendo un articolo di approfondimento per contrastare la disinformazione. Le elezioni del 2020 sono state un grande test, personalmente ho seguito un gruppo di giornalisti americani. Gli aspetti più interessanti di questa esperienza sono due: 1) le piattaforme hanno moltiplicato le modalità di intervento e la rapidità; 2) la comunità di giornalisti investigatori collabora e fa gioco di squadra. In Italia questo tipo di dinamica non esiste ancora e abbiamo un unico caso di collaborazione con la società fondata da Mark Zuckerberg. Si tratta di Pagella Politica/Facta con cui abbiamo anche noi una partnership. Da una dataset che va dal 2017 al 2019 sono state rilevate meno di 200 notizie segnalate come false. Un numero troppo esiguo, che conferma in realtà l’insufficienza dello screening. Inoltre, per i singoli paesi dell’Unione, è praticamente impossibile esercitare una qualsiasi forma di controllo sui social media. L’Europa è un caso ancora diverso. A livello comunitario si è giunti a un Codice di condotta sottoscritto da Facebook e Twitter che impegna le due società a produrre report periodici e alla trasparenza”.

Dove finiscono le bufale?

Il gruppo di ricerca dell’Università di Urbino ha pensato anche a questo aspetto, cioè a rendere pubblici i risultati aggiornati delle fonti processate dal software. Il risultato è una pagina web semplicissima da consultare dove i contenuti critici vengono suddivisi per categoria: news false condivise sulle pagine nelle ultime 24 ore; quelle condivise sui gruppi e, altra sezione, le ultime condivisioni del giorno.

Meme, cause ed effetti

Chiunque si sia imbattuto in un meme può constatarne l’efficacia dal numero di condivisioni. Ma se dovesse rispondere a domanda: quali sono le finalità e gli effetti? Beh, avrebbe qualche difficoltà a trovare una versione convincente. “Le motivazioni che giustificano le condivisioni coordinate sono di varia natura” conclude il professor Giglietto. “Ci sono ragioni commerciali, ideologiche e di visibilità. Spesso queste sono intrecciate tra loro e il fatto di avere a che fare con contenuti con un pubblico molto ampio li rende il mezzo ideale per raggiungere obiettivi diversi. Gli effetti sono infine un altro aspetto molto difficile da rilevare e studiare. Le persone che non hanno un’opinione precisa su un determinato argomento (e sono tante) sono certamente certamente più suscettibili ai condizionamenti. Tanto più quando questi arrivano in un momento nel quale le difese si abbassano, perché è questo che accade quando gli utenti navigano per piacere su siti come Facebook. Detto ciò stabilire quanto le persone siano orientabili è tutt’altro discorso. Sarebbe ideale misurare l’opinione di un campione sottoponendo un questionario prima e dopo l’esposizione a notizie false. Tuttavia non è possibile. Il criterio per stabilire se una notizia sia falsa o meno sarebbe troppo soggettivo. L’altro esperimento perfetto? Le survey di Facebook non riescono a raggiungere un pubblico di massa. Ma installare un software che tracci tutti i movimenti in internet potrebbe essere… È evidente che si tratta di un’altra strada non percorribile…